Neueste Forschungen weisen darauf hin, dass interaktive und kompositorische Deepfakes zwei wachsende Bedrohungsklassen sind.

Der MosaicML-Forscher Davis Blaloch beschreibt interaktive Deepfakes als “die Illusion, mit einer echten Person zu sprechen. Stellen Sie sich vor, ein Betrüger ruft Ihre Großmutter an, und sieht dabei genauso wie Sie und klingt auch wie Sie”. Kompositorische Deepfakes, so Blaloch weiter, gehen noch weiter, indem ein böser Akteur viele Deepfakes erstellt, um eine “synthetische Geschichte” zu kompilieren.”Stellen Sie sich einen Terroranschlag vor, der nie stattgefunden hat, einen erfundenen Skandal oder einen “Beweis” für eine selbstsüchtige Verschwörungstheorie. Eine solche synthetische Geschichte könnte durch reale Handlungen ergänzt werden (z. B. das Inbrandsetzen eines Gebäudes)”, so Blaloch auf twitter[1]New deepfake threats loom, says Microsoft’s chief science officer.

In dem Papier ON THE HORIZON: INTERACTIVE AND COMPOSITIONAL DEEPFAKES, schreibt der Chief Science Officer von Microsoft,Eric Horvitz, dass die zunehmenden Fähigkeiten der diskriminierenden und generativen KI-Methoden einen Wendepunkt erreichen. “Die Fortschritte stellen beispiellose Werkzeuge bereit, die von staatlichen und nichtstaatlichen Akteuren genutzt werden können, um überzeugende Desinformationen zu erstellen und zu verbreiten“, schrieb er und fügte hinzu, dass es immer schwieriger werden wird, Fälschungen von der Realität zu unterscheiden.

Die Herausforderung, so erklärte er, ergibt sich aus der Methodik der generativen adversen Netzwerke (GAN), einer “iterativen Technik, bei der das maschinelle Lernen und die Schlussfolgerungen, die zur Erzeugung synthetischer Inhalte eingesetzt werden, gegen Systeme antreten, die versuchen, die erzeugten Fiktionen von den Tatsachen zu unterscheiden. Im Laufe der Zeit lernt der Generator, den Detektor zu täuschen“. Horvitz weiter: “Mit diesem Prozess, der die Grundlage von Deepfakes bildet, werden weder Mustererkennungstechniken noch Menschen in der Lage sein, Deepfakes zuverlässig zu erkennen“.

Horvitz führte in seiner Schlussfolgerung weiter aus: “Während wir an der Grenze der technologischen Möglichkeiten voranschreiten, müssen wir uns weiterhin mit dem potenziellen Missbrauch der von uns geschaffenen Technologien auseinandersetzen und an der Entwicklung von Bedrohungsmodellen, Kontrollen und Schutzmaßnahmen arbeiten – und uns sektorübergreifend mit den zunehmenden Bedenken, akzeptablen Verwendungsmöglichkeiten, bewährten Verfahren, Abhilfemaßnahmen und Vorschriften befassen.”

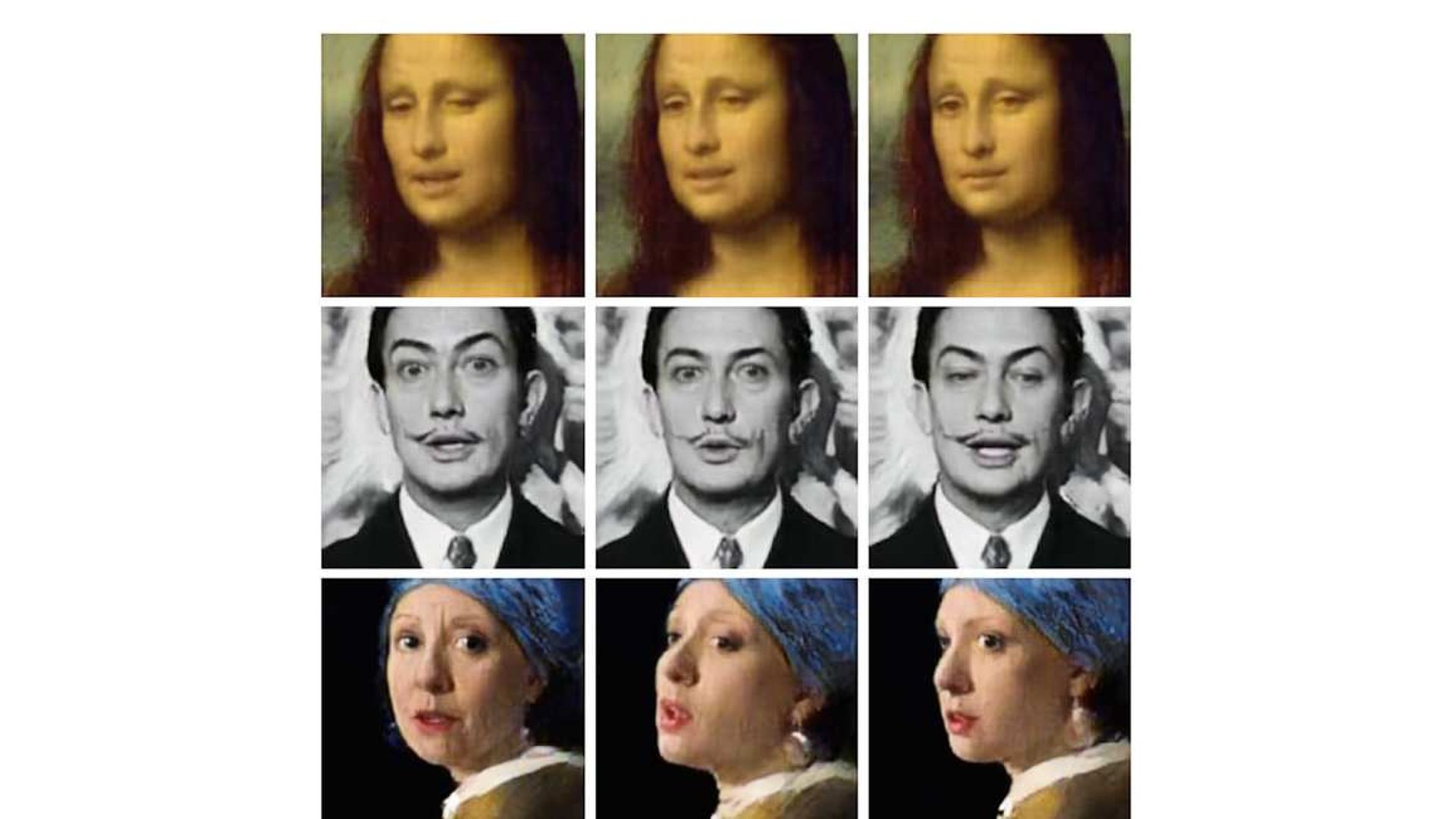

Jonathan Hui stellt einige Methoden vor, anhand derer sich Kompositorische und Synthetische Deepfakes besser erkennen lassen[2]Detect AI-generated Images & Deepfakes (Part 1)[3]Detect AI-generated Images & Deepfakes (Part 2). So wären Design und Implementierung in der Regel mit Unzulänglichkeiten und Fehlern behaftet. Beispielsweise führt die in StyleGAN verwendete Methode der Instanznormalisierung häufig zu Blob-Artefakten und Farbverläufen in den erzeugten Bildern. Dadurch werden die gefälschten Bilder leicht erkennbar. Wie bei anderen GAN- und Deepfakes-Technologien werden jedoch auch hier Gegenmaßnahmen eingeführt. So werden beispielsweise die Blob-Artefakte in StyleGAN bereits durch Gewichtsdemodulation in StyleGAN2 als alternative Normalisierungsmethode behoben.

In dem Paper DeepFake Detection for Human Face Images and Videos: A Survey kommen die Autoren zu dem Schluss: “Die Unfähigkeit zur Übertragung und Verallgemeinerung ist bei den meisten bestehenden Erkennungsmethoden auf der Basis von Deep Learning gegeben, was bedeutet, dass die Multimedia-Forensik ihren Zenit noch nicht erreicht hat. .. Es sind .. noch große Anstrengungen erforderlich, um die Datenintegrität zu gewährleisten, weshalb andere Schutzmethoden erforderlich sind. Außerdem rechnen Experten mit einer neuen Welle von DeepFake-Propaganda in KI-gegen-KI-Begegnungen, bei denen keine der beiden Seiten einen Vorteil gegenüber der anderen hat“.

References